Les scientifiques sont d’accord. Pour affirmer que X cause Y, trois conditions doivent être respectées :

1) X doit se produire avant Y.

2) Il doit y avoir une relation fonctionnelle entre X et Y. Cette relation de cause à effet doit avoir lieu pour au moins 2 valeurs différentes.

3) La dernière condition, souvent négligée, est qu’il ne doit pas y avoir de facteur Z qui cause à la fois X et Y.

Quand vous entendez parler de causalité, demandez-vous si cette affirmation satisfait les 3 critères. La plupart du temps, ce n’est pas le cas.

Le fait qu’on ait besoin de trouver du sens là où il n’y en a aucun rend les choses plus difficiles.

L’inévitabilité des faux positifs

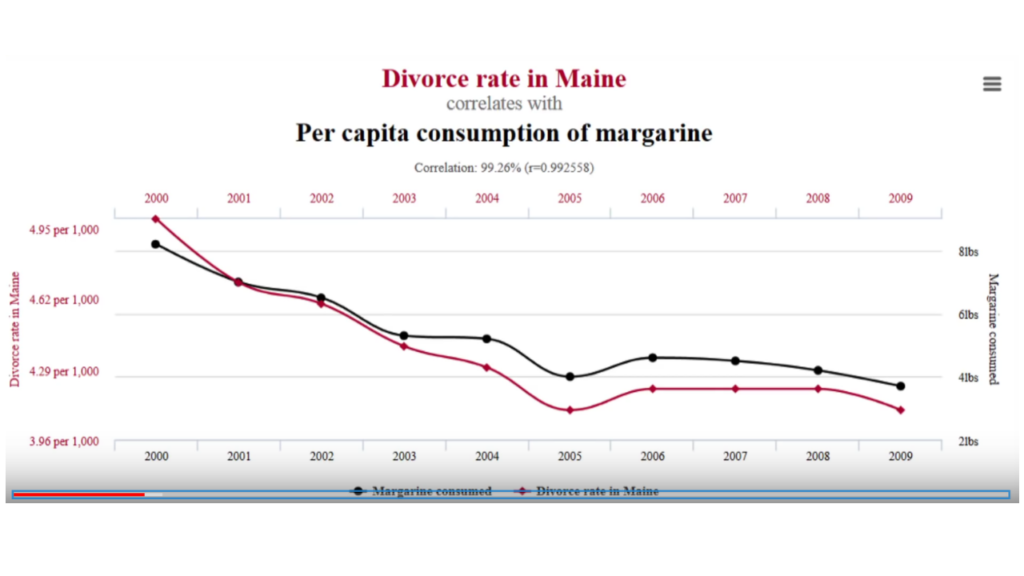

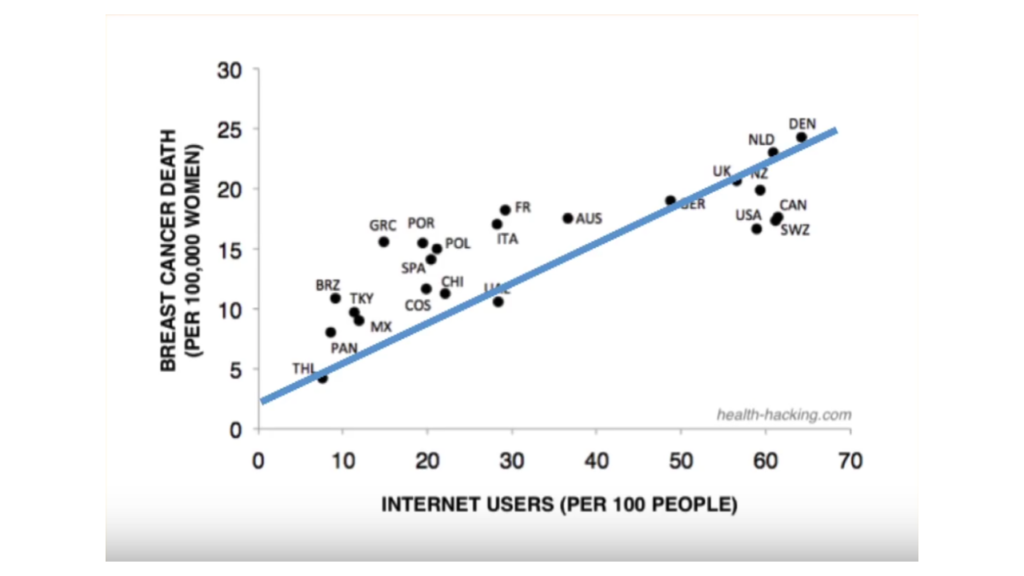

Prenons deux exemples de corrélation dans la présentation Red Meat and Health :

Doit-on en conclure que plus vous mangez de beurre, plus vous avez de risques de divorcer si vous habitez dans le Maine ? Ou que plus il y a de gens sur Internet, plus il y a des femmes qui ont le cancer du sein ?

Ces exemples ridicules illustrent un point important : notre difficulté à faire la différence entre corrélation et causalité. Le problème survient quand on observe une corrélation entre deux variables et qu’on suppose que la première cause la deuxième.

Une fois que vous êtes conscient de cette erreur, vous avez tendance à la voir partout. Les végétariens sont en meilleure santé. Les enfants qui regardent la télévision sont obèses. Jouer aux jeux vidéo rend stupide.

C’est souvent le cas dans tout ce qui touche à la santé ou la nutrition.

Les travers de l’épidémiologie

L’épidémiologie est une discipline scientifique qui étudie les problèmes de santé chez les humains (fréquence, distribution dans le temps et dans l’espace, causes).

Mais les épidémiologistes n’ont que des outils basiques à leur disposition. Ils manquent de précision dans les cas où les risques relatifs sont faibles :

« Dans des études soigneusement préparées, nous pouvons parfois être raisonnablement confiants à propos des risques relatifs élevés ; nous devons rester prudents à propos des risques relatifs proches de 2 ; nous pouvons rarement conclure quoi que ce soit pour les risques juste en-dessous de 2 et quand les résultats sont très inférieurs à 2, game over, il n’y a rien à en tirer. »

Dr. Samuel Shapiro

Si on prend la plus belle réussite de l’épidémiologie à l’heure actuelle – le lien entre la cigarette et le cancer – le risque de mourir d’un cancer des poumons pour les fumeurs est entre 15 et 30 fois supérieures par rapport aux non-fumeurs. Donc quand des journalistes s’appuient sur une étude montrant une augmentation du risque de cancer pour les mangeurs de viande rouge de 17 à 18% (entre 1,17 et 1,18), on peut se poser des questions.

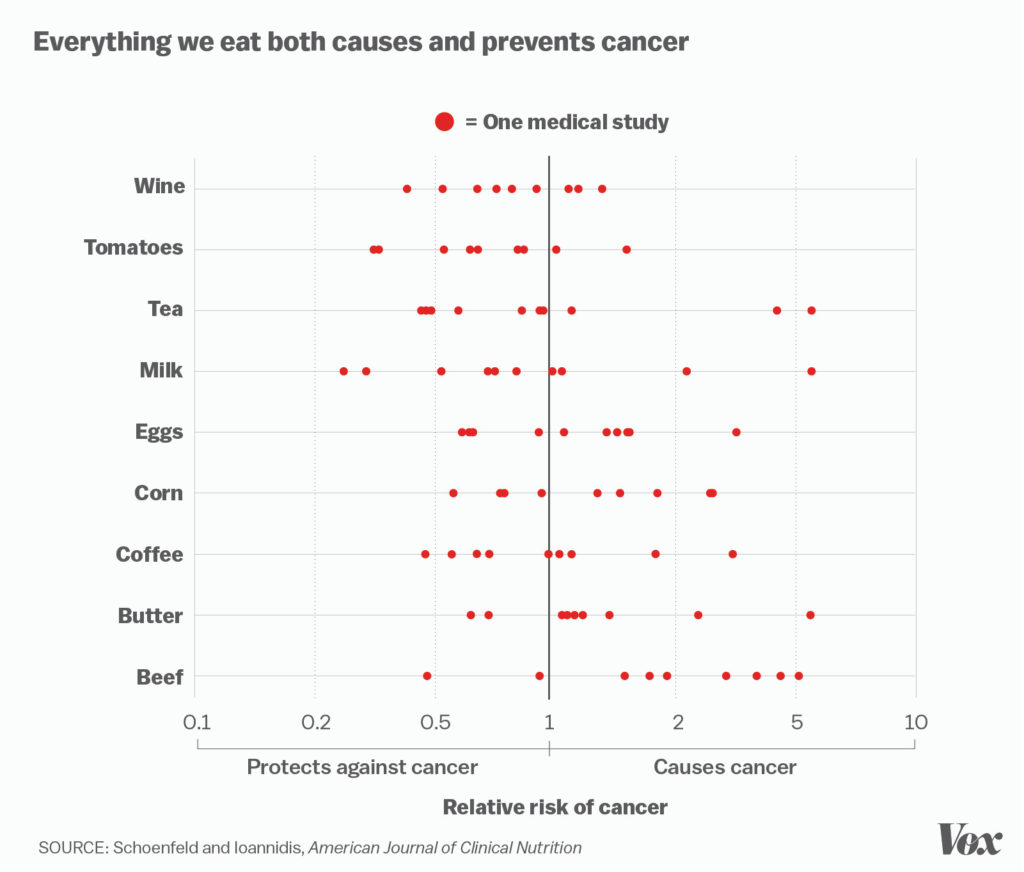

Même si le secteur est à la mode et que les publications se multiplient comme des petits pains (sans gluten, évidemment), la nutrition ne peut pas être qualifiée de science. Il suffit de regarder le tableau suivant :

Il faut arrêter de donner de l’importance à des études uniques et se reporter aux méta-analyses qui combinent les résultats et minimisent les biais inhérents à chacune des études.

L’importance des méta-analyses

Toutes les études sont biaisées d’une façon ou d’une autre. La vérité se trouve généralement dans l’agrégation de ces recherches sur le même sujet. Ça implique que les vraies découvertes ne viennent pas d’un miracle ou d’une inspiration divine. Elles sont le fruit d’un long et laborieux procédé de vérification et de reproductibilité des essais et de discussions entre les différents interlocuteurs. Le but est de s’assurer que les résultats ne sont pas dus à une singularité dans l’une des expériences.

« Il y a une énorme différence entre la façon dont les médias et les scientifiques considèrent les news. Pour les journalistes, ce qui fait les news, c’est par définition ce qui est nouveau – créant un biais dans les médias vers la nouveauté. Mais en sciences, plus les résultats sont récents, plus ils ont de chances d’être faux.«

Naomi Oreskes (professeur en histoire des sciences à Harvard)

L’effet Lindy dans toute sa splendeur.

Les méta-analyses – ces analyses systématiques des meilleures études sur un sujet donné – sont la clé. Quand des scientifiques ou des journalistes annoncent prématurément une découverte révolutionnaire, il y a de fortes chances que ce ne soit pas une avancée du tout. Il faut passer outre la nouveauté et se concentrer sur les domaines où la science s’est accumulée.

La corrélation à l’heure du Big Data

Avec Internet et l’avènement du Big Data, ce problème risque d’empirer. Quand des millions de données sont disponibles, il est facile de trouver des liens entre elles. Si les algorithmes de machine learning se basent sur ces associations aléatoires, on obtient des prédictions fragiles (au sens où l’entend Nassim Taleb). Des prédictions qui voleront en éclat dès qu’un cygne noir pointera le bout de son nez.

Ces modèles étant par définition des boîtes noires, il est difficile de savoir ce qui se passe dedans. On aime à penser que les machines sont impartiales, qu’un algorithme ne peut être biaisé.

Mais quid des ceux qui les programment ?

Il y a fort à parier que d’autres hedge funds connaissent le sort de LTCM, ces génies de la finance qui ont tout perdu à cause de leurs modèles mathématiques infaillibles.